Nel turbinio dell’innovazione globale, l’evoluzione dell’intelligenza artificiale non è solo una questione tecnologia, ma un vero e proprio spartiacque culturale e geopolitico. Non è un caso che qualcuno abbia definito come un “momento Sputnik” gli avvenimenti degli ultimi giorni, richiamando alla mente lo storico evento del lancio del primo satellite artificiale che nel 1957 modificò per sempre l’equilibrio di potere mondiale. Solo che oggi non è una “corsa allo spazio”, ma più che altro una “corsa all’AI”.

DEEPSEEK E IL CONSUMO ENERGETICO DELLE AI

Il lancio in discussione è la recente presentazione di DeepSeek, il modello AI sviluppato da un’azienda cinese, la Hangzhou Deepseek Artificial Intelligence, che ha decisamente scosso il mercato. Promettendo consumi elettrici inferiori rispetto ai concorrenti statunitensi, DeepSeek-V3 ha suscitato l’attenzione globale. Con un investimento iniziale inferiore ai 6 milioni di dollari – in netto contrasto con i più di 100 milioni richiesti per ChatGPT – il modello ha fatto vacillare il monopolio degli Stati Uniti.

Da notare, inoltre, che questo risultato è stato ottenuto nonostante le restrizioni imposte dagli USA sull’esportazione di chip avanzati verso la Cina, dimostrando per tutti che “l’allunaggio” è possibile anche con hardware meno avanzati.

DeepSeek non solo ha dimostrato che non è necessario avere la potenza economica o tecnologica degli Stati Uniti per produrre un modello di Intelligenza artificiale di successo – facendo così rientrare in gara anche la Vecchia Europa – ma anche che è possibile farlo riducendo i consumi elettrici, elemento particolarmente rilevante in un contesto in cui l’espansione dei data center e l’aumento correlato della domanda elettrica sono diventati temi centrali.

Per dare un’idea dei consumi, possiamo riportare delle stime relative a modelli di AI come ChatGPT. I dati variano in base al tipo di utilizzo e alla fase di lavoro, ovvero l’addestramento o l’inferenza (la produzione delle risposte in base alle domande inserite). Alcuni studi, come quello di Strubell dell’ormai lontanissimo 2019, indicano che il training di grandi modelli linguistici può richiedere centinaia o addirittura migliaia di megawattora, a seconda dell’architettura, dell’hardware e delle strategie di ottimizzazione adottate. Tuttavia, fornire cifre esatte risulta difficile, poiché molti dati non sono stati divulgati.

Inoltre, la richiesta di energia è continua. Anche se l’inferenza comporta un consumo energetico nettamente inferiore rispetto all’addestramento, il numero elevato di richieste giornaliere – anche delle semplici domande che vanno dal meteo del giorno a una ricetta – può generare un impatto significativo a livello aggregato, soprattutto nei data center su scala globale. Questo scenario evidenzia come, nonostante gli sforzi per migliorare l’efficienza, l’uso diffuso di modelli di AI rimanga energivoro, sottolineando l’urgenza di sviluppare soluzioni più sostenibili.

Oltre all’elettricità, lo sviluppo dell’AI dipende fortemente dall’acqua necessaria per il raffreddamento dei data center. Nel 2022, le principali aziende tecnologiche come Google, Microsoft e Meta hanno prelevato oltre due miliardi di metri cubi di acqua dolce per questo scopo e si prevede che, entro il 2027, la crescente domanda di AI potrebbe richiedere tra i 4,2 e i 6,6 miliardi di metri cubi d’acqua. Il solo addestramento di GPT-3 di OpenAI – che, come abbiamo detto, è il momento più delicato per un’AI – ha consumato circa 700.000 litri di acqua.

TRA PROGRESSO TECNOLOGICO E REGOLAZIONE

La reazione del mercato azionario alla presentazione di DeepSeek – con il crollo delle azioni di molte società energetiche statunitensi – dimostra quanto il settore sia sensibile alle stime sulla futura domanda di energia legata all’intelligenza artificiale. Forse una paura infondata, da quanto sottolineato da Thomas Spencer dell’AIE che, in un’intervista al Financial Times, frena le domande e ammette che il mercato non dispone ancora degli strumenti adeguati a valutare con precisione l’impatto dell’AI sul consumo elettrico.

Ora che è stato mostrato come “si può fare” con minore consumo energetico, risulta interessante quello che si chiama “paradosso di Jevons”: maggiore è l’efficienza di una tecnologia, maggiore potrebbe essere la sua diffusione e, di conseguenza, l’aumento della domanda di energia. In poche parole, se DeepSeek dovesse mantenere le sue promesse di un’AI meno energivora, ciò potrebbe paradossalmente accelerarne l’adozione su scala globale, aumentando complessivamente la richiesta di risorse energetiche.

I DATA CENTER: UN GAME CHANGER PER IL MERCATO ELETTRICO?

A questa incertezza si aggiunge la crescita dei data center, il vero campo in cui si gioca la partita. Secondo Terna, le richieste di connessione per nuovi data center in Italia hanno raggiunto i 30 GW, un valore venti volte superiore rispetto a tre anni fa. La maggior parte di queste richieste si concentra nel Nord Italia, in particolare in Lombardia e nella zona di Milano, creando potenziali squilibri nella gestione della rete elettrica.

Il problema non è solo infrastrutturale, ma anche autorizzativo: la complessità delle procedure di connessione e l’assenza di un quadro normativo chiaro rallentano la pianificazione strategica della rete. Inoltre, il fabbisogno crescente di energia elettrica per alimentare questi centri porta automaticamente ad una riflessione sulle fonti energetiche da utilizzare per alimentarli con continuità: una situazione che sembra creare nuovo spazio di mercato anche per i CCGT, posto che rinnovabili e accumuli potrebbero non essere in grado di coprire interamente questo fabbisogno anche nel lungo periodo.

Fonte: Visual Capitalist

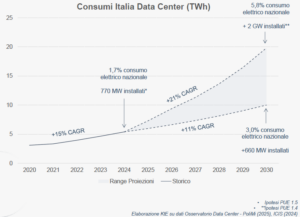

Il tema dello sviluppo dei data center e del loro impatto sui consumi elettrici è stato oggetto di un convegno che si è tenuto a Milano la scorsa settimana. Le analisi presentate da Key to Energy, principale organizzatore del convegno, illustrano una possibile intensa crescita della domanda elettrica indotta dai data center in Italia (attualmente pari al 1.7% del fabbisogno nazionale) sostenuta anche dal progressivo esaurimento dei siti disponibili nei Paesi del nord Europa.

Elaborazione Key to Energy su dati Osservatorio Data Center

Il convegno è stata anche l’occasione per mettere a fuoco la nascente regolazione della materia: con diversi disegni di legge in discussione, si ritiene che il 2025 sarà l’anno per definire le norme che guideranno lo sviluppo del settore definendo meccanismi autorizzativi e di connessione, siti privilegiati per l’installazione, eventuali incentivi o obblighi circa il consumo dell’energia.

Tra le idee, quella di definire una sorta di “open season” per i data center affidando a Terna il compito di indicare le aree dove ci sono maggiori spazi di connessione e premiando chi, tra tutti gli operatori che avanzeranno domanda, arrivi prima ad ottenere un’autorizzazione.

Luigi Michi, Senior Advisor Key to Energy

STOP DEL GARANTE

Se da alcune parti arrivano atteggiamenti di apertura, dall’altro proprio il contrario.

Così com’è stato per il giovane ChatGPT, anche DeepSeek ha attirato l’attenzione del Garante per la Privacy, che ha imposto un blocco temporaneo.

Le autorità, infatti, sono sempre più attente a garantire che lo sviluppo tecnologico non comprometta i diritti e la privacy degli utenti. Ma spesso non riescono a stare al passo del cambiamento: ciò è dimostrato dal fatto che nonostante fosse stato imposto il blocco, la versione browser del ChatBot fosse ancora perfettamente raggiungibile.

Il caso DeepSeek, con la sua promessa di un’intelligenza artificiale più efficiente, riporta in primo piano il triangolo di interesse fatto di innovazione, consumi energetici e normative, rendendo ancora più chiaro il bisogno di agire con strategia.

Il futuro dell’intelligenza artificiale e dell’economia digitale dipenderà dalla capacità di affrontare queste sfide in modo lungimirante, garantendo un equilibrio tra sviluppo tecnologico, tutela dei diritti delle persone, sicurezza energetica e sostenibilità ambientale.